Transfer Learning

- 새로운 task에 대해 학습을 진행하면, 시간과 비용이 많이 든다.

- 비슷한 유형의 task를 수행한 모델을 통해 시간과 비용을 줄일 수 있다.

- 기존에 학습했던 weight를 업데이트 하지 않기 위해 모든 layer를 고정(freeze)한다.

- task별 class의 수가 다를 수 있기 때문에, fully connected layer를 새로 정의하고 이를 학습한다.

Freeze

- 학습 과정에서(back propagation) 해당 층의 parameter를 업데이트 하지 않는것을 layer freeze라 한다.

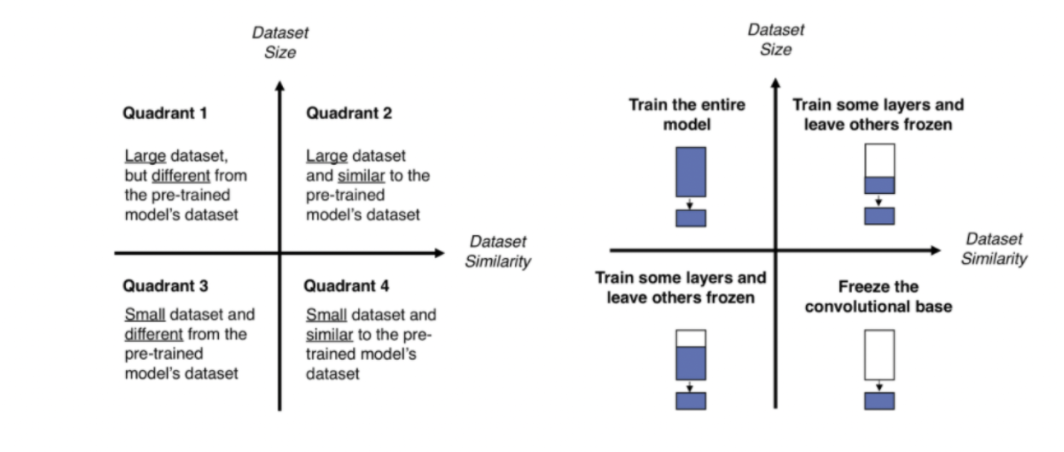

Fine-tuning

- fully connected layer를 학습하는 기존 transfer learning에서, 고정(freeze)하는 layer를 임의로 설정한다.

- Pre-trained 모델은 새로운 task 이미지일지라도 low level(저수준의 특성)에서는 유용하다.

- top layer(입력층과 가까운)의 weight는 고정하고, last layer(출력층과 가까운)는 새로 학습하여 시간과 비용을 줄인다.

Task에 따른 학습 전략

'ML_DL > 딥러닝 공부하기' 카테고리의 다른 글

| Bag of Words (0) | 2024.01.07 |

|---|---|

| Vanishing Gradient Problem(기울기 소실) (0) | 2023.11.28 |

| [자연어처리] Word Embedding (1) | 2023.10.14 |

| 이미지 불러오기 (0) | 2023.08.09 |

| [파이토치로 시작하는 딥러닝] Part-4 RNN (0) | 2023.07.02 |